Sapete dove posso trovare una lista che indichi quale reflex e ISO Invariance e quale no?

In particolare volevo sapere se la d7200 e la d610 lo sono.

Ciao, la Nikon produce molte reflex con sensori a Iso Invariance la D7200 � una di quelle,

per la D610 perso lo stesso ma non ne ho la certezza, controllo .

per la D610 perso lo stesso ma non ne ho la certezza, controllo .

The ISO 100 shot pushed by 5EV is essentially indistinguishable from the native ISO 3200 shot, even down to the darkest tones in the image. This is very impressive performance: the D7200 is probably the closest to being a truly ISO Invariant camera that we've seen. This means that you could reduce ISO (and the hardware amplification that goes with it) by 5EV in order to retain 5EV of highlight detail, then adjust the brightness afterwards with no additional noise cost.

https://m.dpreview.com/reviews/nikon-d7200/13

https://www.dpreview.com/reviews/image-comp...900059844404547

Da questa serie di scatti vedi come la D7200 si comporta meglio della D7100 e dove la D7500 va anche un filo meglio.

Non ho trovato la D610 ma c�� la D750.

Oramai sono tutti ISO invariance.

https://m.dpreview.com/reviews/nikon-d7200/13

https://www.dpreview.com/reviews/image-comp...900059844404547

Da questa serie di scatti vedi come la D7200 si comporta meglio della D7100 e dove la D7500 va anche un filo meglio.

Non ho trovato la D610 ma c�� la D750.

Oramai sono tutti ISO invariance.

perdonatemi,cosa si intende per ISO invariance?

Questo � un vecchio articolo, ma la spiegazione � comunque valida

Qui

In ogni caso, anche il link postato da Carlo (fullerenium2) seppure in inglese, era gi� esaustivo

Saluti

Qui

In ogni caso, anche il link postato da Carlo (fullerenium2) seppure in inglese, era gi� esaustivo

Saluti

Questo � un vecchio articolo, ma la spiegazione � comunque valida

Qui

In ogni caso, anche il link postato da Carlo (fullerenium2) seppure in inglese, era gi� esaustivo

Saluti

Qui

In ogni caso, anche il link postato da Carlo (fullerenium2) seppure in inglese, era gi� esaustivo

Saluti

Grazie!

Questo � un vecchio articolo, ma la spiegazione � comunque valida

Qui

In ogni caso, anche il link postato da Carlo (fullerenium2) seppure in inglese, era gi� esaustivo

Saluti

Qui

In ogni caso, anche il link postato da Carlo (fullerenium2) seppure in inglese, era gi� esaustivo

Saluti

grazie, non sapevo nemmeno dell'esistenza di questa caratteristica.

perdonatemi,cosa si intende per ISO invariance?

In parole povere questi sensori ti danno la possibilit� di aumentare l'esposizione in post

se l'immagine � uscita sottoesposta puoi aumentarla fino a 5 stop e anche pi�,

al contrario si spappola l'immagine.

poi l'esempio al link postato da Rosanna spiega bene.

Mi par di poter dire che almeno in nikon non ci sia stato un cambio netto da variance>invariance ma un graduale miglioramento magari di entit� relativa alla risoluzione del sensore stesso, quindi forse fare un elenco assoluto di corpi variance e altri invariance � un po' fantasioso e quelli di prossima uscita saranno ancora un "po' di pi� invarianti" ristetto agli attuali.

Saro

Saro

In parole povere questi sensori ti danno la possibilit� di aumentare l'esposizione in post

se l'immagine � uscita sottoesposta puoi aumentarla fino a 5 stop e anche pi�,

al contrario si spappola l'immagine.

poi l'esempio al link postato da Rosanna spiega bene.

se l'immagine � uscita sottoesposta puoi aumentarla fino a 5 stop e anche pi�,

al contrario si spappola l'immagine.

poi l'esempio al link postato da Rosanna spiega bene.

ma in parole povere, come avviene? La sensibilit� "base" del sensore non � es. ISO 100?

Il sensore cattura molto pi� di quello che poi "mostra" il RAW converter nelle ombre, cio� praticamente � stata raccolta luce anche nella parte ombra ma poi lo "sviluppo" del RAW col RAW converter la mostra scura?

Se il discorso � pi� complicato meglio una lettura

ma in parole povere, come avviene? La sensibilit� "base" del sensore non � es. ISO 100?

Il sensore cattura molto pi� di quello che poi "mostra" il RAW converter nelle ombre, cio� praticamente � stata raccolta luce anche nella parte ombra ma poi lo "sviluppo" del RAW col RAW converter la mostra scura?

Se il discorso � pi� complicato meglio una lettura

Il sensore cattura molto pi� di quello che poi "mostra" il RAW converter nelle ombre, cio� praticamente � stata raccolta luce anche nella parte ombra ma poi lo "sviluppo" del RAW col RAW converter la mostra scura?

Se il discorso � pi� complicato meglio una lettura

L�amplificazione del segnale pu� essere elettronico o software.

Alcune macchine usano l�amplificazione hardware da iso X ad iso Y e poi applicano amplificazione software per la restante parte.

Tutto dipende da quale parte della scala ISO si vuole mantenere pi� pulita e con pi� dinamica. Alcune preferiscono mantenere una bassa amplificazione per non bruciare le luci e poi migliorare il tutto con una curva tonale software sul jpg.

Qualcosa in pi� qui

https://m.dpreview.com/articles/4241806072/...d-sensitivity/1

Le cose per come la vedo io sono cosi. I parametri che influenzano quanta luce entra e colpisce il sensore sono tempi e diaframmi. Gli iso non incidono su questo, ma � solo la ripetizione del segnale durante la fase di demosaicizzazione. La ripetizione del segnale viene fatto dal processore e dall'algoritmo. Questa fase viene fatta ormai dai moderni software e quindi impostare gli iso diventa quasi influente se si scatta in raw. Da alcuni test in rete si vede persino che foto recuperate in post sono migliori di quelle con iso alti, segno che i programmi come lightroom demosaicizzano meglio del software della reflex. Il discorso della tenuta degli iso � una cosa diversa in quel caso centra il fatto che i sensori ad ogni generazione hanno sempre meno rumore bianco, e quindi consente ripetizioni del segnale sempre + spinte.

ma in parole povere, come avviene? La sensibilit� "base" del sensore non � es. ISO 100?

Il sensore cattura molto pi� di quello che poi "mostra" il RAW converter nelle ombre, cio� praticamente � stata raccolta luce anche nella parte ombra ma poi lo "sviluppo" del RAW col RAW converter la mostra scura?

Se il discorso � pi� complicato meglio una lettura

Il sensore cattura molto pi� di quello che poi "mostra" il RAW converter nelle ombre, cio� praticamente � stata raccolta luce anche nella parte ombra ma poi lo "sviluppo" del RAW col RAW converter la mostra scura?

Se il discorso � pi� complicato meglio una lettura

Fai attenzione stiamo parlando di iso= sensibilit� del sensore, una volta volta erano Variance

per cui producevano un file diverso ad ogni iso utilizzato, e il recupero in post era di 1/2 stop e rispondevano non bene

oggi con la tecnologia del sensore Invariance puoi recuperare fino a 6 stop e sia se scatti a iso alti che se scatti a iso bassi e poi recuperi in post non cambia nulla

ossia cambia ma vedi pochissima differenza e solo se croppato al mm,

naturalmente si i sensori hanno una sensibilt� nativa che pu� essere 100 e poi noi alzando andiamo a modificare questa sensibilit�

su questi nuovi sensori sia che modifichi sia che non modifichi e lasci la nativa � lo stesso fino a 5/6 stop

provate, alzate la luminosit�/esposizione

comunque � sempre meglio scattare con parametri corretti.

Invariance dovrebbe consentire di ottenere lo stesso risultato -in termini di rumore- sia scattando una foto a 6400 Iso (presente l'iso base della fotocamera =100) sia recuperando in post-produzione 6 stop su uno scatto a 100 Iso, quindi sottoesposto. Al contrario con un sensore "iso variance" tale recupero, ma anche inferiore, porta ad un degrado dell'immagine.

Volendo, per simulitudine l'invariance � paragonabile al recupero di sensibilit� fatto forzando lo sviluppo di una pellicola (con tempi e/o temperatura dei bagni) quando la sua latitudine di posa lo consente. Per cui ad esempio una Ilford HP5 � "invariance", mentre buona parte delle pellicole per diapositiva solitamente sono "variance".

Vero poi che alcuni software post-produttivi hanno sviluppato procedure in grado di superare lo stesso risultato di "sviluppo" in macchina di una posa (base 100) esposta al doppio/triplo ecc. di detto valore, avendo affinato anche l'intervento sulla luminanza.

Per�, con tutto ci� e come � gi� stato detto, ai fini di una "perfetta" esposizione quello che vale � la sensibilit� base del sensore, la cui forzatura -per quanto mitigata dal software di bordo o post- determina sempre un degrado del risultato.

Giampaolo

Volendo, per simulitudine l'invariance � paragonabile al recupero di sensibilit� fatto forzando lo sviluppo di una pellicola (con tempi e/o temperatura dei bagni) quando la sua latitudine di posa lo consente. Per cui ad esempio una Ilford HP5 � "invariance", mentre buona parte delle pellicole per diapositiva solitamente sono "variance".

Vero poi che alcuni software post-produttivi hanno sviluppato procedure in grado di superare lo stesso risultato di "sviluppo" in macchina di una posa (base 100) esposta al doppio/triplo ecc. di detto valore, avendo affinato anche l'intervento sulla luminanza.

Per�, con tutto ci� e come � gi� stato detto, ai fini di una "perfetta" esposizione quello che vale � la sensibilit� base del sensore, la cui forzatura -per quanto mitigata dal software di bordo o post- determina sempre un degrado del risultato.

Giampaolo

Fai attenzione stiamo parlando di iso= sensibilit� del sensore, una volta volta erano Variance

per cui producevano un file diverso ad ogni iso utilizzato, e il recupero in post era di 1/2 stop e rispondevano non bene

oggi con la tecnologia del sensore Invariance puoi recuperare fino a 6 stop e sia se scatti a iso alti che se scatti a iso bassi e poi recuperi in post non cambia nulla

ossia cambia ma vedi pochissima differenza e solo se croppato al mm,

naturalmente si i sensori hanno una sensibilt� nativa che pu� essere 100 e poi noi alzando andiamo a modificare questa sensibilit�

su questi nuovi sensori sia che modifichi sia che non modifichi e lasci la nativa � lo stesso fino a 5/6 stop

provate, alzate la luminosit�/esposizione

comunque � sempre meglio scattare con parametri corretti.

per cui producevano un file diverso ad ogni iso utilizzato, e il recupero in post era di 1/2 stop e rispondevano non bene

oggi con la tecnologia del sensore Invariance puoi recuperare fino a 6 stop e sia se scatti a iso alti che se scatti a iso bassi e poi recuperi in post non cambia nulla

ossia cambia ma vedi pochissima differenza e solo se croppato al mm,

naturalmente si i sensori hanno una sensibilt� nativa che pu� essere 100 e poi noi alzando andiamo a modificare questa sensibilit�

su questi nuovi sensori sia che modifichi sia che non modifichi e lasci la nativa � lo stesso fino a 5/6 stop

provate, alzate la luminosit�/esposizione

comunque � sempre meglio scattare con parametri corretti.

per forza � sempre meglio scattare con parametri corretti, senno la foto la vedi nera :-P

il discorso del recupero, significa che dobbiamo scattare bene, ma se dobbiamo aprire le ombre in scene a forte contrasto, non dobbiamo aver paura a farlo perch� sarebbe come scattare due foto a diversa esposizione e poi combinarle.

In un certo senso la famosa esposizione a forchetta oggi la puoi gestire direttamente in post produzione (almeno nella forchetta da 100 a 400 ISO).

In un certo senso la famosa esposizione a forchetta oggi la puoi gestire direttamente in post produzione (almeno nella forchetta da 100 a 400 ISO).

Ricordo discussioni di qualche anno fa dove veniva tassativamente "vietato" fare gli Hdr a casa con un solo scatto, dici che ora quel concetto andrebbe un po' rivisto?

Ricordo discussioni di qualche anno fa dove veniva tassativamente "vietato" fare gli Hdr a casa con un solo scatto, dici che ora quel concetto andrebbe un po' rivisto?

mha.... in genere gli HDR li usi nel paesaggio e nel paesaggio tipicamente si usano bassi ISO. Non ti nascondo che anche con D700 mi � capitato di fare doppio sviluppo, uno per le luci ed uno per le ombre e poi ho fuso con una maschera i due scatti. Nessuna mappa tonale, per� non sembrano finti come gli HDR.

Non ti nascondo che in passato ho fatto largo uso di HDR quello con pi� scatti e poi mappa tonale, ma alla fine mi ero assuefatto ed ho deciso di smettere.

per forza � sempre meglio scattare con parametri corretti, senno la foto la vedi nera :-P

il discorso del recupero, significa che dobbiamo scattare bene, ma se dobbiamo aprire le ombre in scene a forte contrasto, non dobbiamo aver paura a farlo perch� sarebbe come scattare due foto a diversa esposizione e poi combinarle.

In un certo senso la famosa esposizione a forchetta oggi la puoi gestire direttamente in post produzione (almeno nella forchetta da 100 a 400 ISO).

il discorso del recupero, significa che dobbiamo scattare bene, ma se dobbiamo aprire le ombre in scene a forte contrasto, non dobbiamo aver paura a farlo perch� sarebbe come scattare due foto a diversa esposizione e poi combinarle.

In un certo senso la famosa esposizione a forchetta oggi la puoi gestire direttamente in post produzione (almeno nella forchetta da 100 a 400 ISO).

Ogni sensore per la tecnologia che ha on-board reagisce diversamente, recuperi molto fino a 5 stop

per cui si parla di iso molto alti, che una volta si sognavano... basta guardare le tabelle al link sopra e ci si accorge della tenuta

e della differenza di rumore tra i vari sensori provati,

non mi sono mai post questo problema, perch� personalmente curo molto l'esposizione gi� in fase di scatto tant'� che la stessa da me in post viene poco toccata

Vado un attimo OT, ma forse neppure; cos�, solo per tentare una riflessione sull�argomento.

E� vero che il progresso �per� in buona sostanza del solo software- ci consente oggi utilizzi di sensibilit� quasi estreme con recuperi soddisfacenti dell�immagine, ma i sensori restano �vincolati� alla loro sensibilit� nominale (64-100-200Iso solitamente). Quella hanno, per cui anche l�uso della scala Iso che ogni fotocamera permette � solo frutto di una "forzatura" software che poco o tanto qualche degrado all�immagine lo produce.

La vera rivoluzione sarebbe invece �ma da incompetente non saprei neppure se fattibile- quella di un sensore a sensibilit� nominale �variabile�. Magari ho espresso solo un sogno, e qui mi fermo.

Giampaolo

E� vero che il progresso �per� in buona sostanza del solo software- ci consente oggi utilizzi di sensibilit� quasi estreme con recuperi soddisfacenti dell�immagine, ma i sensori restano �vincolati� alla loro sensibilit� nominale (64-100-200Iso solitamente). Quella hanno, per cui anche l�uso della scala Iso che ogni fotocamera permette � solo frutto di una "forzatura" software che poco o tanto qualche degrado all�immagine lo produce.

La vera rivoluzione sarebbe invece �ma da incompetente non saprei neppure se fattibile- quella di un sensore a sensibilit� nominale �variabile�. Magari ho espresso solo un sogno, e qui mi fermo.

Giampaolo

La vera rivoluzione sarebbe invece �ma da incompetente non saprei neppure se fattibile- quella di un sensore a sensibilit� nominale �variabile�. Magari ho espresso solo un sogno, e qui mi fermo.

E' un concetto sbagliato

Il segnale (analogico) prelevato dai singoli fotositi che compongono il sensore viene comunque amplificato e poi convertito in un insieme ordinato di numeri campionando il segnale analogico.

La sensibilit� nominale � solo un valore in cui hai determinati parametri 'ottimali' di amplificazione e altri trattamenti del segnale prima del campionamento.

La capacit� di produrre una rappresentazione digitale di quanto il sensore ha raccolto che sia invariante rispetto agli ISO � per quel che so legata alla qualit� del segnale raccolto dai fotositi in termini di sensibilit� (capacit� di distinguere le differenze di luce ricevuta, rapporto tra segnale e rumore, linearit�, ...) e quindi al fatto che la rappresentazione digitale dell'immagine raccolta possa essere amplificata in post produzione semplicemente moltiplicando i valori di luminosit� per un numero a piacere. Dal punto di vista dell'implemntazione la questione � complessa e sono molte le componenti che partecipano, ma alla fine quello che conta � la capacit� di produrre rappresentazioni pulite della realt� ripresa.

ma alla fine quello che conta � la capacit� di produrre rappresentazioni pulite della realt� ripresa.

Ho premesso che non sono preparato anche perch� la mia formazione professionale � di altro indirizzo.

N� posso -appunto- immaginare la complessit� dei singoli processi e meccanismi hardware/software che concorrono alla formazione finale dell�immagine. Per� la conclusione del mio ragionamento � proprio quanto riporto di tuo, cio� la �capacit� di produrre rappresentazioni pulite�.

E per questo, complicazioni progettuali o esecutive a parte che ripeto, ignoro, l�ideale sarebbe proprio poter disporre di sensori �naturalmente� ricettivi su diverse sensibilit� iso (100, 400, 800 ecc.) in modo da ottenere sempre un risultato �pulito� ad ogni livello di sensibilit� senza dover ricorrere a quanto oggi viene affrontato incrementare la sensibilit� basica via software a bordo e/o in post-produzione. Quanto ci� poi, possa essere coagulabile in unico sensore, o pi� sensori in unica fotocamera, non � un problema che mi pongo, non essendo in grado di esaminarlo n� tanto meno di risolverlo.

Riferendomi alla pellicola -elemento sensibile che ha preceduto l�era digitale, di cui ne esistono con varie sensibilit� nominali (a prescindere che fossero poi ulteriormente �push processing � con lo sviluppo), evidentemente dovute ad una diversa dimensione e distribuzione dei sali d�argento sul supporto oltre ad un diverso trattamento chimico degli stessi- posso solo immaginare in forma digitale analoga modalit� applicata ai pixel sul sensore.

Giampaolo

Un saluto a tutti. Leggendo un po tutti i punti di vista, e le realt� espresse/segnalate fin ora...

Quello che, mi viene da dire con franchezza, visto che si accenna anche il passato... anche quello analogico ...

Invariance o meno... Oggi, ma gi� da ieri, rispettando il pensiero di chi si � posto, o si pone la domanda cercando

una rispettosa soluzione/risposta, immagino importante secondo le proprie "esigenze"...

Personalmente, mi sento di condividere il pensiero, con chi � seriamente convinto che

sul discorso alti iso/gestione del rumore , non esiste paragone con il passato. Sia a livello Hardware e anche software.

Visto la disponibilit� dei vari programmi di sviluppo/PP a disposizione x ogni propria necessit�.

Saluti@Cordialit�

raffaele

Quello che, mi viene da dire con franchezza, visto che si accenna anche il passato... anche quello analogico ...

Invariance o meno... Oggi, ma gi� da ieri, rispettando il pensiero di chi si � posto, o si pone la domanda cercando

una rispettosa soluzione/risposta, immagino importante secondo le proprie "esigenze"...

Personalmente, mi sento di condividere il pensiero, con chi � seriamente convinto che

sul discorso alti iso/gestione del rumore , non esiste paragone con il passato. Sia a livello Hardware e anche software.

Visto la disponibilit� dei vari programmi di sviluppo/PP a disposizione x ogni propria necessit�.

Saluti@Cordialit�

raffaele

...

Riferendomi alla pellicola -elemento sensibile che ha preceduto l�era digitale, di cui ne esistono con varie sensibilit� nominali (a prescindere che fossero poi ulteriormente �push processing � con lo sviluppo), evidentemente dovute ad una diversa dimensione e distribuzione dei sali d�argento sul supporto oltre ad un diverso trattamento chimico degli stessi- posso solo immaginare in forma digitale analoga modalit� applicata ai pixel sul sensore.

...

Riferendomi alla pellicola -elemento sensibile che ha preceduto l�era digitale, di cui ne esistono con varie sensibilit� nominali (a prescindere che fossero poi ulteriormente �push processing � con lo sviluppo), evidentemente dovute ad una diversa dimensione e distribuzione dei sali d�argento sul supporto oltre ad un diverso trattamento chimico degli stessi- posso solo immaginare in forma digitale analoga modalit� applicata ai pixel sul sensore.

...

L'equivalente (con moltissimi distinguo) della pellicola pi� sensibile (sali d'argento a grana pi� grossa) � un sensore con bassa densit� di pixel.

I costruttori di sensori le studiano naturalmente tutte per raccogliere ogni singolo fotone anteponendo micro lenti a i fotositi e usando la luce riflessa dalla parte 'posteriore' del sensore (BSI).

Quindi dal mio punto di vista non ha senso pensare a sensori da 100, 200 o 3200 ISO, perch� semplicemente i costruttori di sensori cercheranno di raccogliere la maggior quantit� di luce possibile, con i fotositi pi� piccoli possibile e poi dovranno per forza fare i conti con una pi� o meno grande amplifucazione dei segnali in gioco.

Forzando sempre i paragoni con la pellicola (anch eio sono dell'idea che non sia troppo il caso):

- Il sensore con i suoi fotositi di certe dimensioni, di efficienza pi� o meno alta corrisponde ad una pellicola di determiniata sensibilit� (nominale) che non puoi cambiare perch� � un parametro costruttivo

- L'aumento degli ISO in sede di esposizione corrisponde al tiraggio che facevamo della pellicola; il trattamento pi� aggressivo (tempi e temperature dei bagni di sviluppo) contribuiva ad amplificare l'effetto delle reazioni chimiche innescate dalla luce che aveva colpito la pellicola stessa

- Il recupero delle ombre in un programam di elaborazione RAW corrisponde alle operazioni che facevamo in camera oscura quando sceglievamo la carta, il tempo di esposizione e ancora la durata dei bagni

Il tema di cui si sta discutendo � seconodo me legato alla capacit� di misurare finemente, con grande precisione ed evitando di sovrapporre qualuque segnale spurio (rumore in priomis) piccole quantit� di luce che trasformate in segnali elettrici e opportunamente campionati generino numeri da 14 bit (base per la maggior parte dei sensori moderni) che una volta raddoppiati per 5-6 volte e messi in fila producano immagini realistiche.

Dal punto di vista matematico in un RAW a 14 bit ho spazio per 2^14 sfumature per ciascuna componente di colore RGB.

Sono pi� di 16 mila per singola componente che in tottale producono 4 miliardi di possibili sfumature totali.

Pensiamo ora di sottoesporre un'immagine di 6 stop e recuperarla in post produzione.

Se divido 2^14 per 6 (i 6 stop di sottoesposizione) ottengo 2^8 che significa 256 sfumature (per componente di colore RGB).

In realt� le sfumature nelle zone d'ombra sono meno, (altrimenti con la moltiplicazione otterrei un'immagine completamente bianca).

I moderni sensori (e tuta l'eletronica collegata) riescono a misurare la luce cos� bene che la rappresentazione di ombre in poche decine di gradazioni (sempre per singola componete RGB) � 'pulita' abbastanza da non notare noi poi un degrado peggiore di quello che otterremmo amplificando prima il segnale analogico dei fotositi e sfruttando fin da subito l'intera scala a 14 bit.

Ovviamente la matematica dice che un'esposizione corretta ci dar� il maggior numero di sfumature su cui lavorare.

Allora, leggetevi tutto d�un fiato questo articolo e poi continuiamo :-)

https://photographylife.com/iso-invariance-explained

https://photographylife.com/iso-invariance-explained

Allora, leggetevi tutto d�un fiato questo articolo e poi continuiamo :-)

https://photographylife.com/iso-invariance-explained

https://photographylife.com/iso-invariance-explained

La mia autonomia sui testi in inglese � di 4 righe

La mia autonomia sui testi in inglese � di 4 righe

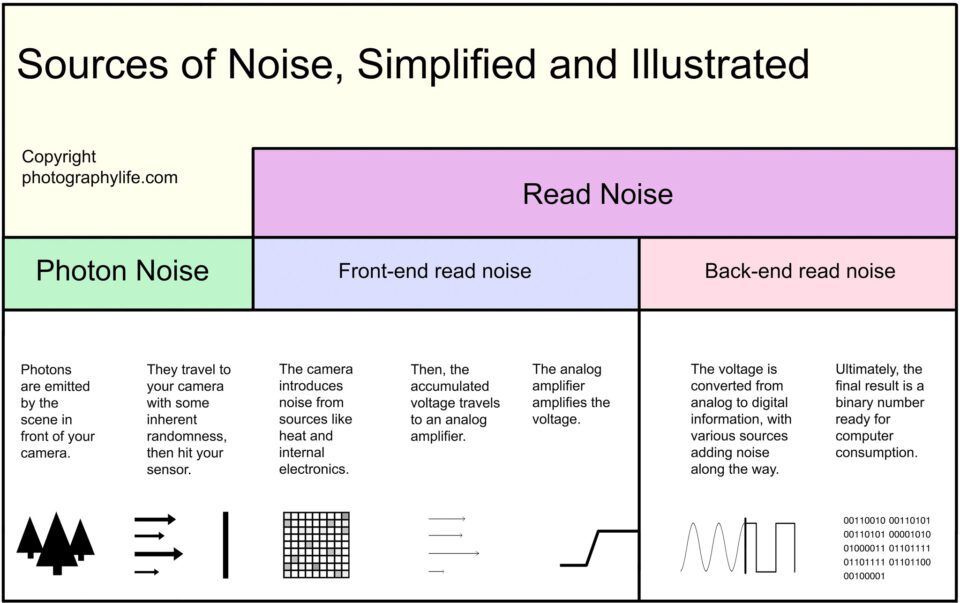

Allora guardati questa figura dallo stesso indirizzo

L'articolo conclude sintetizzando che minore � il cosidetto back-end read noise e pi� si pu� dire che la macchina � ISO invariant.

In pratica � la capacit� di convertire (campionare) i segnali analogici in valori digitali senza aggiungere informazioni spurie (rumore) che rende quella rappresentazione numerica fedele all'originale ripreso e che quindi permette di ottenere risultati soddisfacenti (almeno quanto quelli ottenuti alzando gli ISO) semplicemente moltiplicando quei valori per un numero grande a piacere (abbiamo visto fino ad un massimo di 2^5 - 2^6) ovvero muovendo il cursore 'esposizione' di Lightroom.

Io ho provato a descrivere quello che l'articolo dice pi� sopra ed in modo semplificato.

L'argomento � tecnico ed anche l'articolo citato da fullerenium2 di fatto adotta un approccio semplificato

Non ci resta che tornare a scattare, le nostre macchine ci regalano cos� tanto spazio di manovra che alla fine: viva la creativit�!

Non ci resta che tornare a scattare, le nostre macchine ci regalano cos� tanto spazio di manovra che alla fine: viva la creativit�!

Giusta conclusione. Visto che sommando all'estro del fotografo (si spera che ne abbia anche se, per quanto mi riguarda, non ne sono tanto sicuro) l'odierna tecnologia, ce ne sono di fotografie da fare, belle o brutte che siano. Ma per sbagliarle occorre un impegno importante.

La mia autonomia sui testi in inglese � di 4 righe

Basta tradurre automaticamente la pagina ed il gioco � fatto...

ragazzi non ci fasciamo tanto la testa, nelle prime righe si era gi� detto tutto, l'utente penso abbia capito,

e poi il concetto giralo come vuoi, argomentalo come ti pare, la conclusione � sempre la solita,

invariance o variance la foto va fatta bene in partenza e poi in post un lieve aggiustamento si fa sempre a prescindere...

un esempio di vera fotocamera ISO invariance secondo me � la Fuji X-T100.

La Z6 invece usa un dual gain e da ISO 800 fare un push di 3 Stop � esattamente come scattare a 6400 ISO. Diverse fotocamere odierne hanno un salto "quantico a 800 ISO" , segno che utilizzano un circuito di amplificazione diverso nel range 100-400 e 800-6400.

Infatti se qui http://www.photonstophotos.net/Charts/RN_e.htm caricate le fotocamere che volete analizzare vedrete quello che si verifica da questi scatti https://www.dpreview.com/reviews/image-comp...767772511848314

La D500 dal grafico � chiaro che ha il salto a 400 ISO, ed infatti scattare gi� a 400ISO e fare un push di +3 stop � come scattare a 3200 ISO.

La Z6 invece usa un dual gain e da ISO 800 fare un push di 3 Stop � esattamente come scattare a 6400 ISO. Diverse fotocamere odierne hanno un salto "quantico a 800 ISO" , segno che utilizzano un circuito di amplificazione diverso nel range 100-400 e 800-6400.

Infatti se qui http://www.photonstophotos.net/Charts/RN_e.htm caricate le fotocamere che volete analizzare vedrete quello che si verifica da questi scatti https://www.dpreview.com/reviews/image-comp...767772511848314

La D500 dal grafico � chiaro che ha il salto a 400 ISO, ed infatti scattare gi� a 400ISO e fare un push di +3 stop � come scattare a 3200 ISO.

quindi se non ho capito male, in una situazione dove hai bisogno di tempi brevi volendo si pu� scattare a iso bassi per poi recuperare in post il risultato in termine di rumore non cambia o solo di poco? in pratica come si faceva una volta in camera oscura pellicola 100 iso e dove serviva in via eccezionale un 400 iso tiravi la pellicola in camera oscura di 1/stop o 2/stop

quindi se non ho capito male, in una situazione dove hai bisogno di tempi brevi volendo si pu� scattare a iso bassi per poi recuperare in post il risultato in termine di rumore non cambia o solo di poco? in pratica come si faceva una volta in camera oscura pellicola 100 iso e dove serviva in via eccezionale un 400 iso tiravi la pellicola in camera oscura di 1/stop o 2/stop

Diciamo che la frase corretta sarebbe stata: posso lavorare a bassi ISO, ad un certo punto ho bisogno di tempi molto brevi ma non ho voglia di stare a cambiare gli ISO (aumentare gli ISO) per cui le foto mi verranno sottoesposte (il diaframma obiettivo � gi� tutto aperto). Nessun problema, tanto recupero la sottoesposizione in post che nella maggior parte dei casi da lo stesso risultato che aumentare gli ISO in fase di scatto.

Se vedi il grafico della D4s su photons to photos, capisci subito che gli ISO intermedi sono tutti simulati cio� la sensibilit� non � amplificata via hardware ma software.

La D5 non � per niente ISO invariance. Se ce l’hai puoi fare da te la prova.

Salta a inizio pagina | Per vedere la versione completa del forum Clicca qui.